Noticias

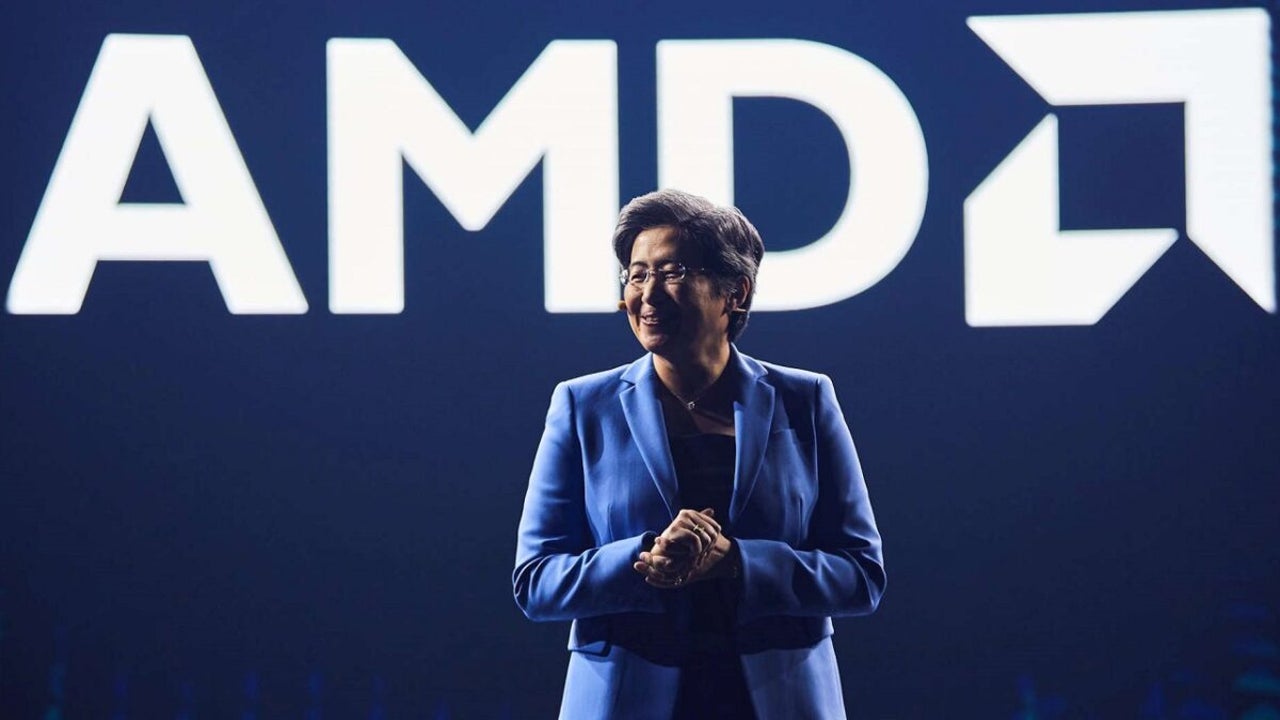

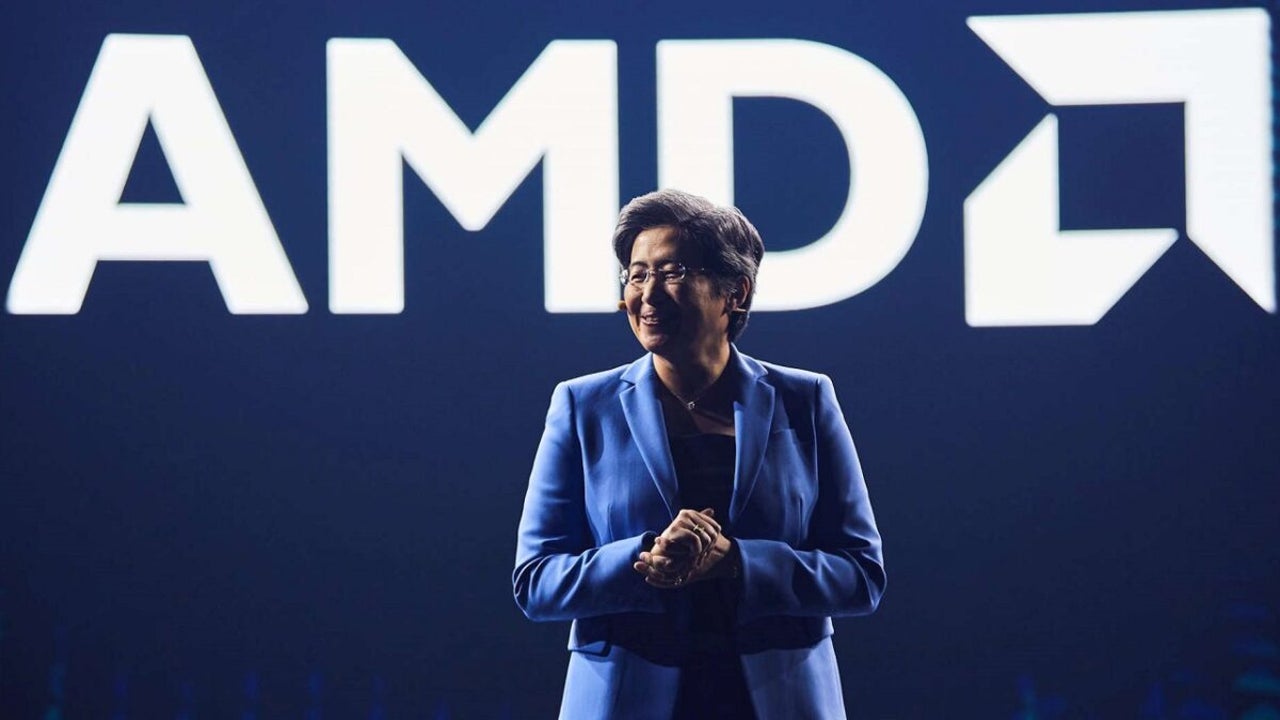

AMD entra de lleno en la IA con su primer LLM

La gran rival de Nvidia comienza a ser una apuesta segura en el mundo de la IA

- 6 de noviembre de 2024

- Actualizado: 19 de noviembre de 2024, 6:44

AMD ha presentado su primera serie de grandes modelos de lenguaje (LLM) de 1.000 millones de parámetros y código abierto, denominada AMD OLMo, dirigida a diversas aplicaciones y preentrenada en las GPU Instinct MI250 de la compañía.

Suscríbete a la Newsletter de Softonic y recibe las últimas noticias en tech, juegos, entretenimiento en tu buzón de correo

Suscríbete (es GRATIS) ►Los LLM de código abierto de AMD pretenden mejorar la posición de la compañía en la industria de la IA y permitir a sus clientes (y a todo el mundo) implantar estos modelos de código abierto con el hardware de AMD.

Al hacer públicos los datos, los pesos, las recetas de entrenamiento y el código, AMD pretende permitir a los desarrolladores no solo reproducir los modelos, sino también basarse en ellos para seguir innovando.

Más allá del uso en centros de datos, AMD ha permitido el despliegue local de modelos OLMo en PCs AMD Ryzen AI equipados con unidades de procesamiento neural (NPUs), permitiendo a los desarrolladores aprovechar los modelos de IA en dispositivos personales.

Todo lo que sabemos sobre el LLM de AMD

Los modelos AMD OLMo se entrenaron en un amplio conjunto de datos de 1,3 billones de tokens en 16 nodos, cada uno con cuatro GPU AMD Instinct MI250 (64 procesadores en total). La línea de modelos OLMo de AMD se entrenó en tres pasos.

En las propias pruebas de AMD, los modelos OLMo de AMD mostraron un rendimiento impresionante frente a modelos de código abierto de tamaño similar, como TinyLlama-1.1B, MobiLlama-1B y OpenELM-1_1B en pruebas de referencia estándar para capacidades de razonamiento general y comprensión multitarea.

El modelo SFT de dos fases experimentó mejoras significativas en la precisión, con un aumento del 5,09% en las puntuaciones de MMLU y del 15,32% en GSM8k, lo que demuestra el impacto del enfoque de entrenamiento de AMD.

El modelo final AMD OLMo 1B SFT DPO superó a otros modelos de chat de código abierto en al menos un 2,60% de media en las pruebas comparativas.

Además, AMD probó pruebas de IA responsables, como ToxiGen (que mide el lenguaje tóxico, donde una puntuación más baja es mejor), crows_pairs (que evalúa la parcialidad) y TruthfulQA-mc2 (que evalúa la veracidad en las respuestas). Y se comprobó que los modelos OLMo de AMD estaban a la par con modelos similares en el manejo de tareas de IA éticas y responsables.

Content Manager - Periodista especializado en tecnología, entretenimiento y videojuegos. Escribir sobre lo que me apasiona (cacharros, juegos y cine) me permite seguir cuerdo y despertarme con una sonrisa cuando suena el despertador. PD: esto no es cierto el 100 % de las veces.

Lo último de Chema Carvajal Sarabia

- Nintendo pone más stock de la Switch 2 en su tienda oficial: corre que vuelan

- Ya hemos probado la Nintendo Switch 2: os contamos todo lo que queréis saber

- Google ya no es la que era: trabajar para ellos ya no el sueño de todo ingeniero

- Ya tenemos fecha de lanzamiento para GTA 6 y la mala noticia es que no será en 2025

También te puede interesar

Noticias

Noticias2XKO es el juego de lucha de Riot Games y quiere hacer lo imposible: ser accesible para novatos y profundo para fans del género

Leer más

Noticias

NoticiasWindows por fin soluciona 80 problemas de ciberseguridad candentes

Leer más

Noticias

NoticiasSi quieres sobrevivir a la IA, olvida el SEO: es la hora del GEO

Leer más

Noticias

NoticiasEl creador de ‘Andor’ disfrutó de ‘The Mandalorian’, pero nunca llegó a terminársela. “Era desorientadora”

Leer más

Noticias

NoticiasJohn Travolta se enfrentará a un chófer con IA y asesino en su primera película de terror en 50 años

Leer más

Noticias

NoticiasUno de los mejores actores de Hollywood rechazó ‘La bella y la bestia’ de Guillermo del Toro

Leer más